China está desarrollando Un modelo de inteligencia artificial (IA). Es una sensación en varios frentes, incluida su naturaleza de código abierto y su capacidad para manejar hasta 200.000 tokens de contexto.

La nueva IA de la serie Yi supera ampliamente a otros modelos populares como Claude de Anthropic (100.000 tokens) o el GPT-4 Turbo de OpenAI (128.000 tokens). La Beijing Lingyi Wanwu Information Technology Company es la encarga de crear este nuevo chatbot generativo progresivo en su laboratorio de inteligencia artificial.

El chatbot 01.AI. posee un modelo de lenguaje grande (LLM) y se presenta en dos versiones, el liviano Yi-6B-200K y el más robusto Yi-34B-200K. Sin embargo, ambos son capaces de retener un inmenso contexto conversacional y comprender inglés y mandarín.

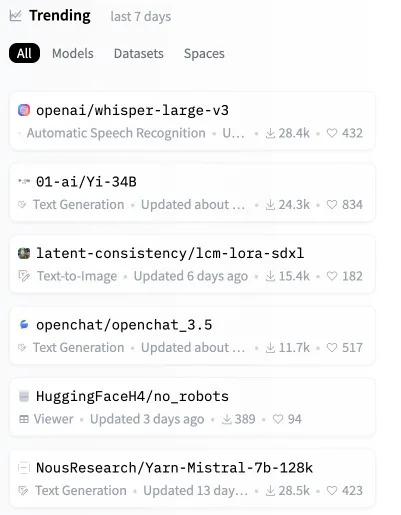

A tan solo horas de su lanzamiento, el modelo Yi se disparó en las listas hasta convertirse en el segundo modelo de código abierto más popular en Hugging Face, un repositorio clave para modelos de IA.

Te puede interesar: Google va Contra Estafadores que Explotan el Entusiasmo por la IA

La 01.AI de China es muy superior

Los modelos YI ya manejan enormes indicaciones contextuales, también son muy eficientes y precisos. Esto los coloca por encima de otros LLM en varios puntos de referencia sintéticos.

Pressure Testing GPT-4-128K With Long Context Recall

128K tokens of context is awesome – but what's performance like?

I wanted to find out so I did a “needle in a haystack” analysis

Some expected (and unexpected) results

Here's what I found:

Findings:

* GPT-4’s recall… pic.twitter.com/nHMokmfhW5— Greg Kamradt (@GregKamradt) November 8, 2023

El Yi-34B supera a modelos mucho más grandes como LLaMA2-70B y Falcon-180B; además, el tamaño del Yi-34B puede admitir aplicaciones de forma rentable, lo que permite a los desarrolladores crear proyectos fantásticos.

Explicación tomada del sitio web de 01.AI

Hay que destacar que los modelos de lenguaje grandes (LLM), como la serie Yi, funcionan analizando y generando resultados basados en el lenguaje. Su funcionamiento proviene de procesar tokens o unidades de texto, que pueden ser tan pequeñas como una palabra o parte de una palabra.

La compañía asegura que el modelo Yi es más potente y mostró un sólido rendimiento en comprensión lectora, razonamiento de sentido común y pruebas de inteligencia artificial comunes como Gaokao y C-eval.

![El Ideal Tecnolibertario, Bitcoin y la Cripto Revolución [2/2] Bitcoin y la cripto revolución tecnolibertaria.](https://mundocriptomonedas.b-cdn.net/wp-content/uploads/2025/09/unnamed-1bfr-218x150.png)

![El Ideal Tecnolibertario, Bitcoin y la Cripto Revolución [2/2] Bitcoin y la cripto revolución tecnolibertaria.](https://mundocriptomonedas.b-cdn.net/wp-content/uploads/2025/09/unnamed-1bfr-356x364.png)

![El Ideal Tecnolibertario, Bitcoin y la Cripto Revolución [1/2] Bitcoin y la cripto revolución tecnolibertaria.](https://mundocriptomonedas.b-cdn.net/wp-content/uploads/2025/09/unnamed12-356x364.png)